: 全面解析爬虫技术在加密

2025-07-12

随着加密货币市场的发展,数据挖掘和信息收集的重要性日益凸显。在这个动态变化的环境中,爬虫技术为投资者、研究人员和开发者提供了强大的数据获取能力。本文将全面探讨爬虫技术在加密货币交易中的应用、安全性、相关问题及解决方案,同时回答五个相关问题,以帮助读者更深入理解这一技术的价值。

爬虫技术,或称网络爬虫,是自动抓取互联网上信息的程序或脚本。在加密货币领域,爬虫被广泛应用于以下几个方面:

爬虫技术可以从各种交易所和金融网站收集实时价格、交易量、市场情绪等数据。这些数据对于投资决策至关重要,帮助投资者了解市场趋势和潜在机会。

爬虫能够实时监测竞争对手的价格、活动及新产品发布,从而为公司的战略决策提供有力的数据支持。

社交媒体对加密货币的影响不可小觑。通过分析平台上的讨论和新闻报道,爬虫可以提供关于市场情绪的重要数据,帮助投资者及时调整策略。

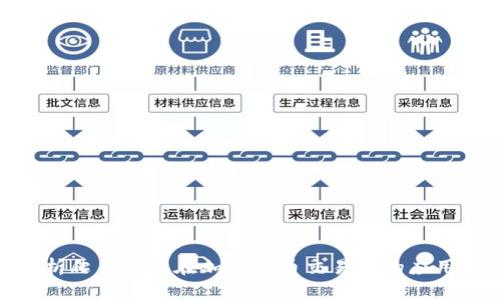

在区块链技术中,爬虫可以用来提取链上数据、交易信息和智能合约的相关数据。这种数据对于开发者和研究人员来说至关重要,有助于他们分析区块链网络的运行状态和安全性。

尽管爬虫技术为加密货币行业带来了诸多优势,但其安全性问题也不容忽视:

许多网站对数据采集有一定的限制,爬虫在抓取数据时若未遵循相关法律法规,可能导致数据隐私泄露。网站管理员可能会采取法律行动以保护其数据资产。

大量的请求会导致目标网站的负载增加,甚至造成拒绝服务攻击(DDoS)。这不仅影响目标网站的正常运行,还可能对爬虫发起方造成法律风险。

爬虫抓取的数据往往需要经过清洗和处理,垃圾数据和不准确的信息会直接影响到决策的有效性。因此,构建有效的数据校验机制至关重要。

互联网技术和网站结构在不断变化,爬虫的算法需要定期进行更新和调整,确保能够持续有效地抓取所需数据。

以下是与爬虫技术和加密货币相关的五个问题及其详细解答:

爬虫技术在加密货币投资中的优势主要体现在实时数据获取、市场趋势分析、精准决策支持等方面。通过设置自动化的爬虫程序,投资者可以随时掌握市场动态,及时作出相应的交易决策。此外,爬虫可以帮助投资者识别和评估潜在的风险,通过大量数据的对比和分析,提供一个更加全面的市场视图。

这种技术的应用不仅提高了信息获取的效率,还减少了人工收集数据的错误率。例如,通过自动抓取不同交易所的价格,投资者可以在不同平台间快速寻找套利机会,从而提高收益。

为了确保爬虫的合法性,首先需要遵循网站的Robots.txt文件中的协议。这个文件定义了网站希望爬虫遵循的行为规范。此外,投资者还需要重视数据隐私法规,确保在爬取用户数据时遵循相关法律。

例如,许多网站禁止未经授权的数据获取,爬虫开发者应该与网站方沟通,获得明确的许可。在实施数据爬虫时,要保持透明,尊重数据的知识产权,避免升级为法律纠纷。

提高爬虫效率和准确性的方法包括使用高效的抓取框架(如Scrapy、BeautifulSoup、Selenium等),合理配置并行抓取的任务。同时,出于数据准确性的考虑,建议在抓取后使用数据清洗技术,以处理重复数据和格式错误。

此外,引入机器学习算法分析抓取的数据,能够帮助识别和过滤出无效和错误信息,提高数据处理的智能化水平。并且,可以使用分布式爬虫架构,将任务分散在不同的节点上,以提升抓取能力。

爬虫在大量请求数据时可能会导致目标服务器的资源耗尽,形成DDoS攻击。如果爬虫设计不当,持续对目标网站发起大量请求,可能会干扰其正常运营,进而触发防火墙或其他安全措施。

为了避免风险,爬虫开发者需在设计时考虑请求频率、间隔和总请求量。同时,可以采用代理IP池技术,分散请求来源,从而降低对目标网站的压力,确保平稳抓取。

反爬虫技术是网站为保护自身数据所采取的措施。为了减少被检测的风险,开发者可以采用多种技术手段:设置随机的User-Agent,轮换访问IP,设置请求频率等。

另外,爬虫应模仿人类的访问行为,结合使用浏览器模拟(如Selenium),降低被识别为爬虫的概率。此外,定期评估目标网站的变化,及时调整爬虫策略,也是防止被反爬虫机制监测的重要手段。

总结来说,爬虫技术在加密货币领域的潜力与挑战并存。合理运用爬虫技术,将为加密货币投资者带来可观的市场信息与数据支持,但同时也需关注技术应用的合规性和安全性问题。通过科学有效的爬虫策略,投资者能够在瞬息万变的市场中把握机遇,有效规避风险。